MNN Chat(手机大模型应用)

MNN Chat是基于MNNLLM的手机大模型应用,能在手机端独立运行多种大型模型。有多模态功能,CPU推理性能提升,模型兼容广,本地化运行,体积小巧,支持离线工作。核心功能适合部署,多平台兼容,算子库丰富。

MNN Chat(手机大模型应用)优势

1. 核心功能强大:模型推理支持CPU、GPU,独立无依赖,代码结构精简,适合部署至移动设备及各类嵌入式系统。

2. 多平台适配性佳:针对iOS平台,提供功能完整的MNN静态库,支持armv7及arm64架构;对于Android平台,核心功能以armv7a架构的cshared动态库形式提供。

3. 节省资源:支持Mini编辑选项,可进一步缩减包体积;具备模型压缩与量化功能,支持FP16、Int8格式,可有效降低模型体积。

4. 兼容性广泛:兼容Tensorflow、Caffe、ONNX、Torchscripts等多种主流模型文件格式,适配多种主流网络架构;广泛适用于服务器、个人电脑、手机以及具有POSIX接口的嵌入式设备,操作系统兼容性强。

MNN Chat(手机大模型应用)特色

1. 多模态功能丰富:涵盖文本到文本、图像到文本、音频转文本以及文本生成图像等多种应用场景。

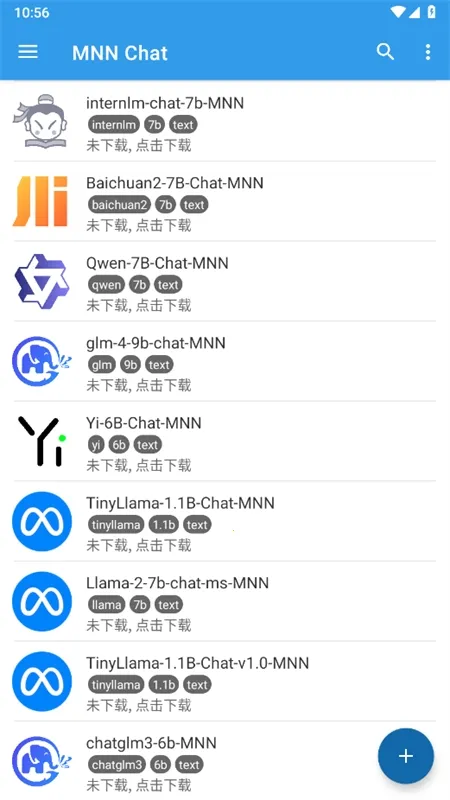

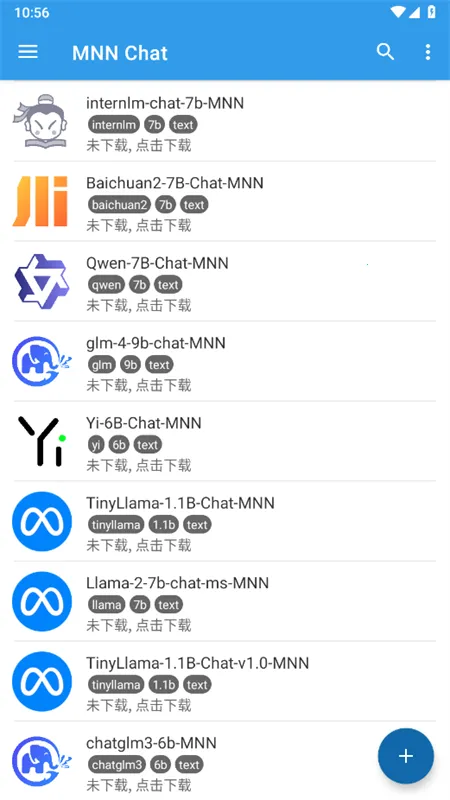

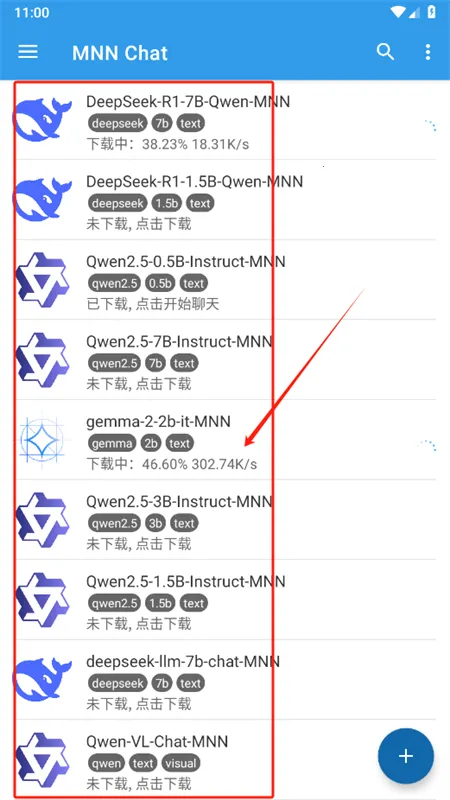

2. 模型兼容范围广:支持众多知名模型提供商,如Qwen、Gemma、Llama等。

3. 本地化运行保隐私:所有操作均在设备本地执行,保障数据隐私安全,无需上传至外部服务器。

4. 体积小巧不占空间:APK安装包体积紧凑,核心引擎仅约800KB,节省存储空间,对设备性能影响微乎其微。

MNN Chat(手机大模型应用)怎么样

MNN Chat是一款出色的手机大模型应用。它基于MNNLLM,能在手机端独立运行大型模型,像DeepSeek、Qwen等。其优势众多,多模态功能涵盖多种应用场景;在安卓平台CPU推理性能大幅提升,预填充速度提升8.6倍,解码速度加快2.3倍。模型兼容范围广,支持众多知名模型提供商。本地化运行保障数据安全,体积小巧轻便,APK安装包仅约800KB。还能离线工作,无需网络。总之,它为用户带来便捷高效且安全的大模型使用体验,值得一试。

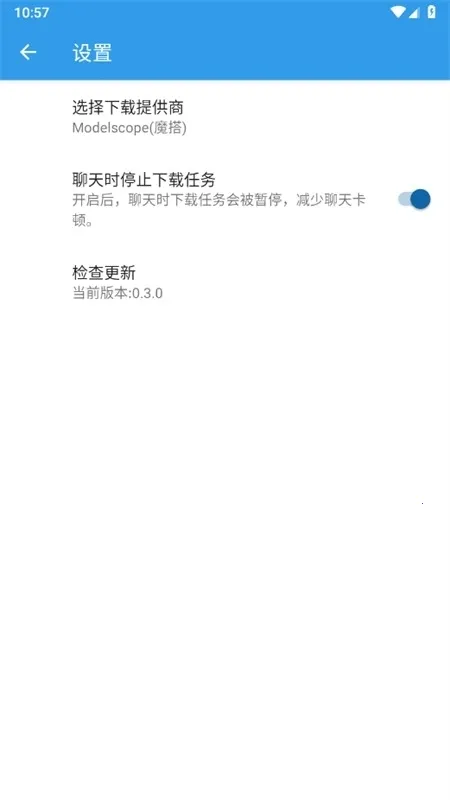

MNN Chat怎么用?MNN Chat使用教程

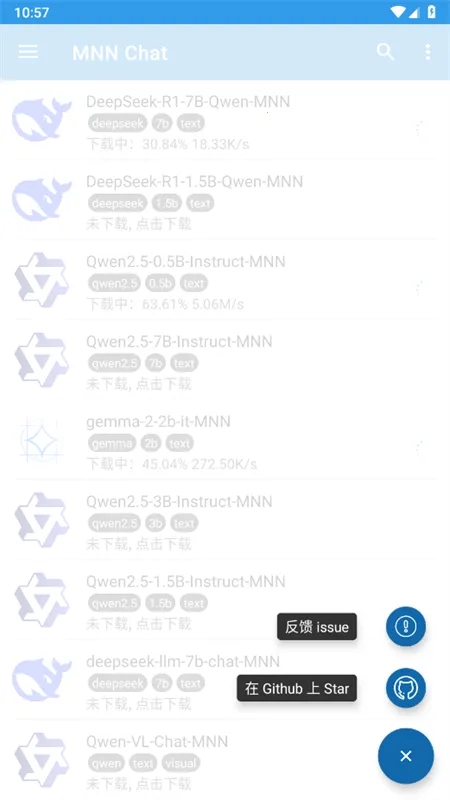

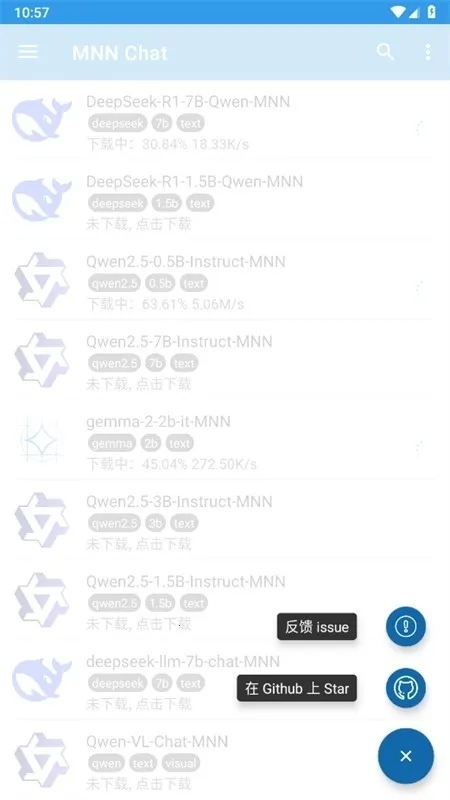

1、在宝贝游戏网下载安装软件,打开后进入主页

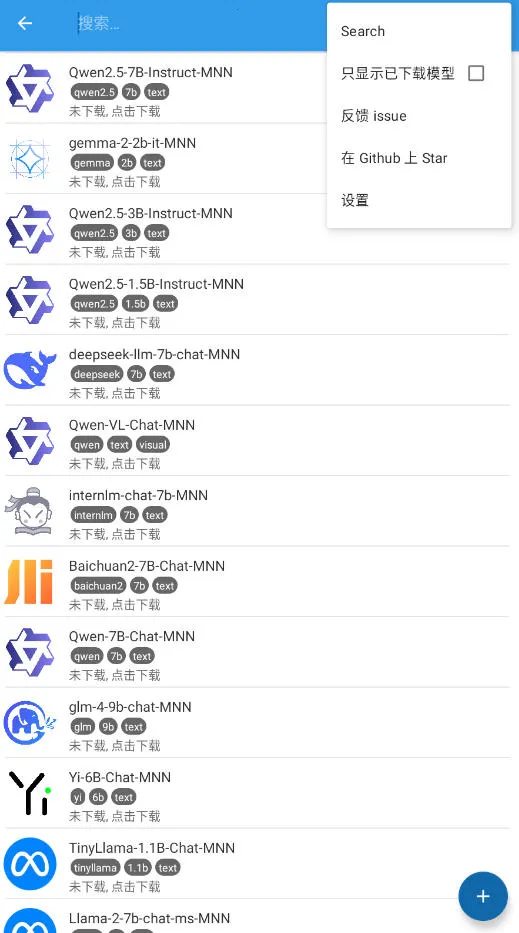

2、进入主页可以看到AI模型,大家可以根据自己的需求选择想要部署的AI模型

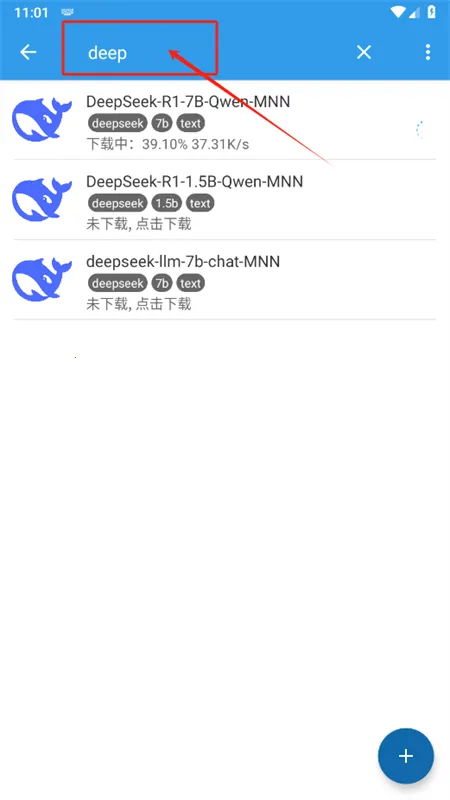

3、然后选择需要下载的文件,直接点击就能快速下载

4、还可以在搜索框输入关键词进行搜索下载